In questo tutorial Hadoop sui Big Data , ti forniremo una descrizione dettagliata del blocco dati Hadoop HDFS. Prima di tutto, tratteremo cos'è il blocco di dati in Hadoop, qual è la loro importanza, perché la dimensione dei blocchi di dati HDFS è 128 MB.

Discuteremo anche l'esempio dei blocchi di dati in hadoop e vari vantaggi di HDFS in Hadoop.

Introduzione al blocco dati HDFS

Hadoop HDFS dividere file di grandi dimensioni in piccoli blocchi noti come Blocchi . Block è la rappresentazione fisica dei dati. Contiene una quantità minima di dati che possono essere letti o scritti. HDFS memorizza ogni file come blocchi. Il client HDFS non ha alcun controllo sul blocco come la posizione del blocco, Namenode decide tutte queste cose.

Per impostazione predefinita, la dimensione del blocco HDFS è 128 MB che puoi modificare secondo le tue esigenze. Tutti i blocchi HDFS hanno le stesse dimensioni tranne l'ultimo blocco, che può essere della stessa dimensione o inferiore.

Il framework Hadoop suddivide i file in blocchi da 128 MB e quindi li archivia nel file system Hadoop. L'applicazione Apache Hadoop è responsabile della distribuzione del blocco di dati su più nodi.

Esempio-

Supponiamo che la dimensione del file sia 513 MB e stiamo utilizzando la configurazione predefinita della dimensione del blocco di 128 MB. Quindi, il framework Hadoop creerà 5 blocchi, i primi quattro blocchi 128 MB, ma l'ultimo blocco sarà solo di 1 MB.

Quindi dall'esempio è chiaro che non è necessario che in HDFS ogni file archiviato debba essere un multiplo esatto della dimensione del blocco configurato 128 MB, 256 MB ecc. Pertanto, il blocco finale per il file utilizza solo lo spazio necessario.

Perché il blocco HDFS ha una dimensione di 128 MB?

HDFS memorizza terabyte e petabyte di dati. Se la dimensione del blocco HDFS è 4kb come il file system Linux, avremo troppi blocchi di dati in Hadoop HDFS, quindi troppi metadati.

Quindi, il mantenimento e la gestione di questo enorme numero di blocchi e metadati creerà enormi spese generali e traffico, cosa che non vogliamo.

La dimensione del blocco non può essere così grande che il sistema attende molto tempo prima che un'ultima unità di elaborazione dati termini il suo lavoro.

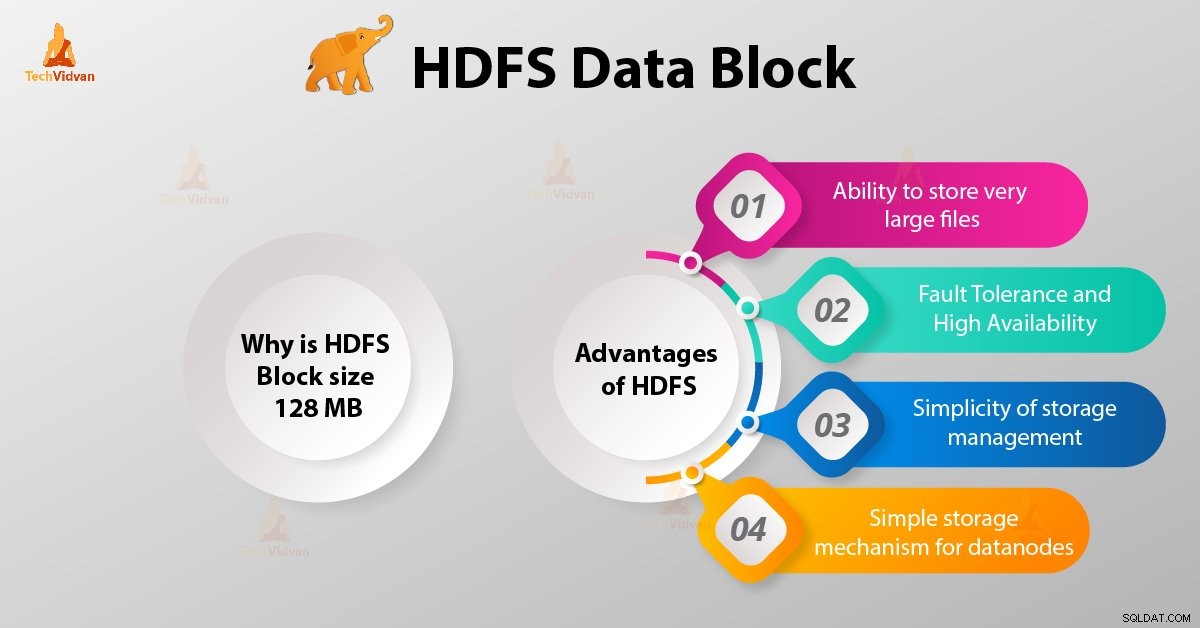

Vantaggi di HDFS

Dopo aver appreso cos'è il blocco dati HDFS, discutiamo ora i vantaggi di Hadoop HDFS.

1. Possibilità di archiviare file molto grandi

Hadoop HDFS archivia file molto grandi che sono anche più grandi delle dimensioni di un singolo disco poiché il framework Hadoop suddivide il file in blocchi e li distribuisce su vari nodi.

2. Tolleranza ai guasti e alta disponibilità di HDFS

Il framework Hadoop può replicare facilmente i blocchi tra i nodi di dati. Pertanto, fornisci tolleranza ai guasti e elevata disponibilità HDFS.

3. Semplicità di gestione dello storage

Poiché HDFS ha una dimensione del blocco fissa (128 MB), è molto facile calcolare il numero di blocchi che possono essere archiviati sul disco.

4. Semplice meccanismo di archiviazione per i nodi di dati

Block in HDFS semplifica l'archiviazione dei Datanode . Nome mantiene i metadati di tutti i blocchi. HDFS Datanode non deve preoccuparsi dei metadati dei blocchi come i permessi dei file ecc.

Conclusione

Quindi, il blocco dati HDFS è l'unità di dati più piccola in un filesystem. La dimensione predefinita del blocco HDFS è 128 MB che è possibile configurare secondo i requisiti. I blocchi HDFS sono facili da replicare tra i nodi di dati. Quindi, fornisci la tolleranza agli errori e l'elevata disponibilità di HDFS.

Per qualsiasi domanda o suggerimento relativo ai blocchi di dati Hadoop HDFS, faccelo sapere lasciando un commento in una sezione indicata di seguito.