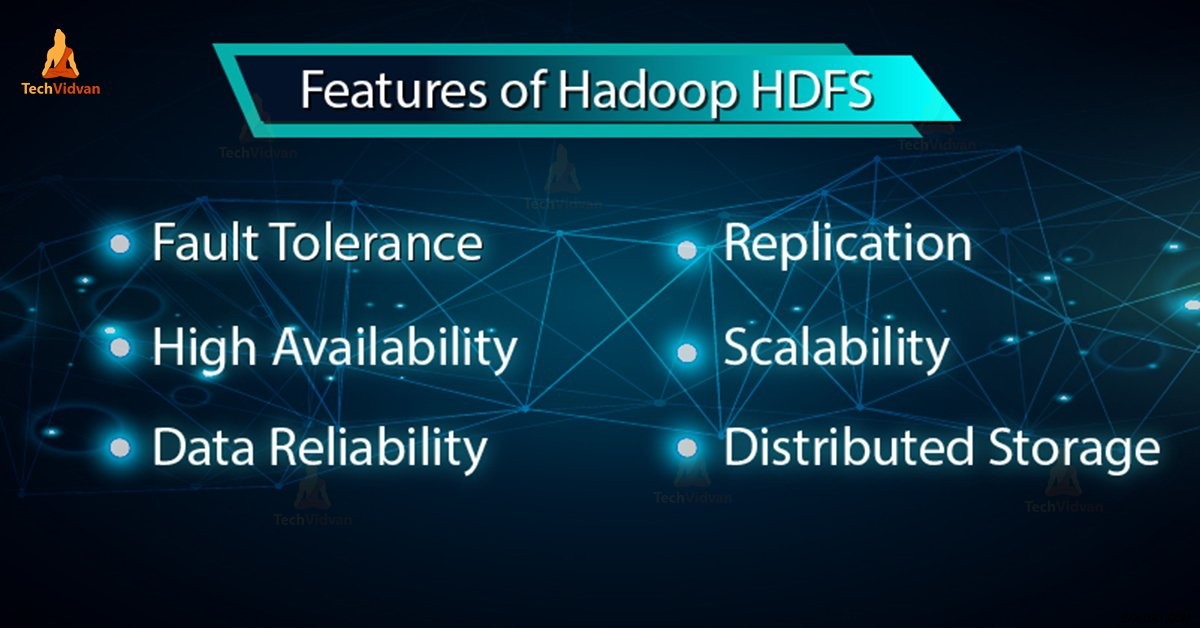

Nel nostro blog precedente abbiamo imparato Hadoop HDFS in dettaglio, ora in questo blog, tratteremo le funzionalità di HDFS. Hadoop HDFS ha funzionalità come tolleranza ai guasti, replica, affidabilità, alta disponibilità, archiviazione distribuita, scalabilità ecc.

Tutte queste funzionalità di HDFS in Hadoop verranno discusse in questo tutorial di Hadoop HDFS.

Introduzione a Hadoop HDFS

File system distribuito Hadoop (HDFS) è il sistema di archiviazione principale di Hadoop. Memorizza file molto grandi in esecuzione su un cluster di hardware di base. HDFS è basato su GFS (Google FileSystem). Memorizza i dati in modo affidabile anche in caso di guasto hardware.

HDFS fornisce anche un accesso ad alta velocità all'applicazione accedendo in parallelo. Secondo una previsione entro la fine del 2017, il 75% dei dati disponibili sul pianeta risiederà in HDFS.

6 Funzionalità importanti di HDFS

Dopo aver studiato l'introduzione di Hadoop HDFS, discutiamo ora le caratteristiche più importanti di HDFS.

1. Tolleranza ai guasti

La tolleranza ai guasti in Hadoop HDFS è la forza operativa di un sistema in condizioni sfavorevoli. È altamente tollerante ai guasti. Il framework Hadoop divide i dati in blocchi. Successivamente crea più copie di blocchi su macchine diverse nel cluster.

Pertanto, quando una macchina nel cluster si arresta, un client può accedere facilmente ai propri dati dall'altra macchina che contiene la stessa copia dei blocchi di dati.

2. Alta disponibilità

Hadoop HDFS è un file system a disponibilità elevata. In HDFS, i dati vengono replicati tra i nodi nel cluster Hadoop creando una replica dei blocchi sugli altri slave presenti nel cluster HDFS. Quindi, ogni volta che un utente desidera accedere a questi dati, può accedere ai propri dati dagli slave che contengono i suoi blocchi.

Al momento di situazioni sfavorevoli come un guasto di un nodo, un utente può accedere facilmente ai propri dati dagli altri nodi. Perché copie duplicate dei blocchi sono presenti sugli altri nodi nel cluster HDFS.

3. Alta affidabilità

HDFS fornisce un'archiviazione dati affidabile. Può memorizzare dati nell'intervallo di 100 petabyte. HDFS archivia i dati in modo affidabile su un cluster. Divide i dati in blocchi. Il framework Hadoop archivia questi blocchi sui nodi presenti nel cluster HDFS.

HDFS archivia i dati in modo affidabile creando una replica di ogni singolo blocco presente nel cluster. Quindi fornisce una struttura di tolleranza ai guasti. Se il nodo nel cluster contenente i dati si interrompe, un utente può accedere facilmente a quei dati dagli altri nodi.

HDFS di default crea 3 repliche di ogni blocco contenente i dati presenti nei nodi. Quindi, i dati sono rapidamente disponibili per gli utenti. Quindi l'utente non deve affrontare il problema della perdita di dati. Pertanto, HDFS è altamente affidabile.

4. Replica

La replica dei dati è una caratteristica unica di HDFS. La replica risolve il problema della perdita di dati in condizioni sfavorevoli come guasti hardware, crash dei nodi, ecc. HDFS mantiene il processo di replica a intervalli di tempo regolari.

HDFS continua inoltre a creare repliche dei dati utente su diverse macchine presenti nel cluster. Quindi, quando un nodo si interrompe, l'utente può accedere ai dati da altre macchine. Pertanto, non vi è alcuna possibilità di perdere i dati dell'utente.

5. Scalabilità

Hadoop HDFS archivia i dati su più nodi nel cluster. Pertanto, ogni volta che i requisiti aumentano, puoi ridimensionare il cluster. In HDFS sono disponibili due meccanismi di scalabilità:Verticale e scalabilità orizzontale.

6. Stoccaggio distribuito

Tutte le funzionalità di HDFS sono ottenute tramite l'archiviazione e la replica distribuite. HDFS archivia i dati in modo distribuito tra i nodi. In Hadoop, i dati sono suddivisi in blocchi e archiviati sui nodi presenti nel cluster HDFS.

Successivamente HDFS crea la replica di ogni singolo blocco e archivia su altri nodi. Quando una singola macchina nel cluster si arresta in modo anomalo, possiamo accedere facilmente ai nostri dati dagli altri nodi che contengono la sua replica.

Conclusione

In conclusione, possiamo dire che HDFS è altamente tollerante ai guasti. Memorizza in modo affidabile enormi quantità di dati nonostante i guasti hardware. Fornisce inoltre un'elevata scalabilità e un'elevata disponibilità. Quindi HDFS potenzia la funzionalità Hadoop. Se trovi altre funzionalità di HDFS, condividi con noi nella sezione commenti qui sotto.