In questo tutorial di Hadoop, discuteremo delle 10 migliori caratteristiche di Hadoop. Se non hai familiarità con Apache Hadoop, puoi fare riferimento alla nostra Introduzione ad Hadoop blog per ottenere una conoscenza dettagliata del framework Apache Hadoop.

In questo blog esamineremo le funzionalità più importanti di Big Data Hadoop come Hadoop Fault Tolerance, Distributed Processing in Hadoop, Scalability, Affidabilità, Alta disponibilità, economica, flessibilità, località dei dati in Hadoop.

Introduzione a Hadoop

Hadoop è un framework software open source che supporta l'archiviazione distribuita e l'elaborazione di enormi quantità di set di dati. È lo strumento per big data più potente sul mercato grazie alle sue caratteristiche. Funzionalità come tolleranza ai guasti, affidabilità, alta disponibilità ecc.

Hadoop fornisce-

- HDFS – Livello di archiviazione più affidabile al mondo

- MapReduce – Strato di elaborazione distribuito

- FILO – Livello di gestione delle risorse

Caratteristiche importanti di Hadoop per big data

Ci sono così tante funzionalità fornite da Apache Hadoop. Discutiamo in dettaglio queste caratteristiche di Hadoop.

a. Open source

È un framework di programmazione basato su Java open source. Open source significa che è disponibile gratuitamente e anche noi possiamo cambiarne il codice sorgente secondo le tue esigenze.

b. Tolleranza ai guasti

Hadoop controlla gli errori dal processo di creazione della replica. Quando il client archivia un file in HDFS, il framework Hadoop divide il file in blocchi. Quindi il client distribuisce i blocchi di dati su diverse macchine presenti nel cluster HDFS.

E, quindi, creare la replica di ogni blocco su altre macchine presenti nel cluster. HDFS, per impostazione predefinita, crea 3 copie di un blocco su altre macchine presenti nel cluster.

Se una macchina nel cluster si arresta o si guasta a causa di condizioni sfavorevoli. Inoltre, l'utente può accedere facilmente a quei dati da altre macchine.

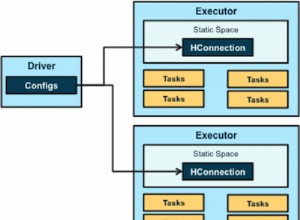

c. Elaborazione distribuita

Hadoop memorizza enormi quantità di dati in modo distribuito in HDFS. Elabora i dati in parallelo su un cluster di nodi.

d. Scalabilità

Hadoop è una piattaforma open source. Questo lo rende una piattaforma estremamente scalabile. Quindi, nuovi nodi possono essere facilmente aggiunti senza tempi di inattività. Hadoop fornisce scalabilità orizzontale in modo che il nuovo nodo venga aggiunto al volo al sistema. In Apache hadoop, le applicazioni vengono eseguite su più di migliaia di nodi.

es. Affidabilità

I dati vengono archiviati in modo affidabile sul cluster di macchine nonostante il guasto della macchina dovuto alla replica dei dati. Quindi, se uno qualsiasi dei nodi si guasta, anche noi possiamo archiviare i dati in modo affidabile.

f. Alta disponibilità

A causa delle copie multiple dei dati, i dati sono altamente disponibili e accessibili nonostante i guasti hardware. Quindi, qualsiasi macchina disattiva i dati possono essere recuperati dall'altro percorso. Scopri in dettaglio la funzionalità di alta disponibilità di Hadoop.

g. Economico

Hadoop non è molto costoso in quanto viene eseguito sul cluster di hardware di base. Poiché utilizziamo hardware di base a basso costo, non abbiamo bisogno di spendere un'enorme quantità di denaro per aumentare la scalabilità del tuo cluster Hadoop.

io. Flessibilità

Hadoop è molto flessibile in termini di capacità di gestire tutti i tipi di dati. Si occupa di strutturati, semi-strutturati o non strutturati.

j. Facile da usare

Non c'è bisogno del client per occuparsi dell'informatica distribuita, il framework si occupa di tutte le cose. Quindi è facile da usare.

k. Località dei dati

Si riferisce alla capacità di spostare il calcolo vicino a dove risiedono i dati effettivi sul nodo. Invece di spostare i dati nel calcolo. Ciò riduce al minimo la congestione della rete e aumenta l'over throughput del sistema. Ulteriori informazioni su Località dati.

Conclusione

In conclusione, possiamo dire che Hadoop è altamente tollerante ai guasti. Memorizza in modo affidabile enormi quantità di dati nonostante i guasti hardware. Fornisce alta scalabilità e alta disponibilità.

Hadoop è efficiente in termini di costi poiché funziona su un cluster di hardware di base. Hadoop lavora sulla località dei dati poiché il calcolo in movimento è più economico dello spostamento dei dati. Tutte queste caratteristiche di Big Data Hadoop lo rendono potente per l'elaborazione di Big Data.