I database relazionali per molto tempo sono stati sufficienti per gestire dataset di piccole o medie dimensioni. Ma il ritmo colossale con cui i dati crescono rende impraticabile l'approccio tradizionale all'archiviazione e al recupero dei dati. Questo problema viene risolto dalle nuove tecnologie in grado di gestire i Big Data. Hadoop, Hive e Hbase sono le piattaforme popolari per gestire questo tipo di set di dati di grandi dimensioni. I database NoSQL o Non solo SQL come MongoDB® forniscono un meccanismo per archiviare e recuperare i dati in un modello di coerenza perdente con vantaggi come:

- Ridimensionamento orizzontale

- Maggiore disponibilità

- Accesso più rapido

Il team di ingegneri di MongoDB® ha recentemente aggiornato il connettore MongoDB® per Hadoop per una migliore integrazione. Questo rende più facile per gli utenti Hadoop:

- Integra i dati in tempo reale da MongoDB® con Hadoop per analisi offline profonde.

- Il connettore espone la potenza analitica di MapReduce di Hadoop ai dati delle applicazioni in tempo reale da MongoDB®, generando valore dai big data in modo più rapido ed efficiente.

- Il connettore presenta MongoDB come un file system compatibile con Hadoop che consente a un lavoro MapReduce di leggere direttamente da MongoDB® senza prima copiarlo su HDFS (Hadoop file System), eliminando così la necessità per spostare terabyte di dati attraverso la rete.

- I lavori MapReduce possono passare le query come filtri, evitando così la necessità di scansionare intere raccolte, e possono anche sfruttare le ricche capacità di indicizzazione di MongoDB® tra cui geo-spaziale, testo- ricerca, array, indici composti e sparsi.

- Leggendo da MongoDB®, i risultati dei lavori Hadoop possono anche essere riscritti in MongoDB®, per supportare processi operativi in tempo reale e query ad hoc.

Casi d'uso Hadoop e MongoDB®:

Diamo un'occhiata a una descrizione di alto livello di come MongoDB® e Hadoop possono integrarsi in un tipico stack di Big Data. Principalmente abbiamo:

- MongoDB® utilizzato come archivio dati in tempo reale "Operativo"

- Hadoop per elaborazione e analisi di dati batch offline

Continua a leggere per sapere perché MongoDB è il database per l'elaborazione dei Big Data e come MongoDB® è stato utilizzato da aziende e organizzazioni come Aadhar, Shutterfly, Metlife ed eBay.

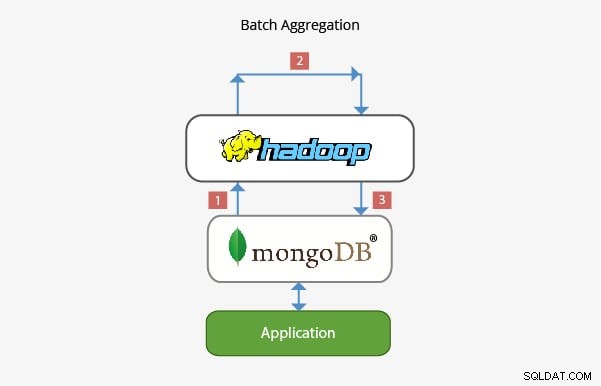

Applicazione di MongoDB® con Hadoop in Batch Aggregation:

Nella maggior parte degli scenari, la funzionalità di aggregazione integrata fornita da MongoDB® è sufficiente per l'analisi dei dati. Tuttavia, in alcuni casi, potrebbe essere necessaria un'aggregazione di dati significativamente più complessa. È qui che Hadoop può fornire un potente framework per analisi complesse.

In questo scenario:

- I dati vengono estratti da MongoDB® ed elaborati all'interno di Hadoop tramite uno o più processi MapReduce. I dati possono anche provenire da altri luoghi all'interno di questi lavori MapReduce per sviluppare una soluzione di origine multi-dati.

- L'output di questi lavori MapReduce può quindi essere riscritto in MongoDB® per essere interrogato in una fase successiva e per qualsiasi analisi su base ad hoc.

- Le applicazioni basate su MongoDB® possono quindi utilizzare le informazioni dell'analisi batch per presentarle al cliente finale o per abilitare altre funzionalità a valle.

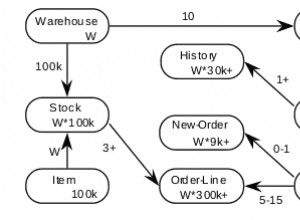

Applicazione in Data Warehousing:

In una tipica configurazione di produzione, i dati dell'applicazione possono risiedere su più archivi dati, ciascuno con il proprio linguaggio di query e funzionalità. Per ridurre la complessità in questi scenari, Hadoop può essere utilizzato come data warehouse e fungere da repository centralizzato per i dati provenienti dalle varie fonti.

In questo tipo di scenario:

- I lavori Periodic MapReduce caricano i dati da MongoDB® in Hadoop.

- Una volta che i dati di MongoDB® e di altre fonti sono disponibili in Hadoop, è possibile eseguire query sul set di dati più grande.

- Gli analisti di dati ora hanno la possibilità di utilizzare MapReduce o Pig per creare lavori che interrogano i set di dati più grandi che incorporano i dati di MongoDB®.

Il team che lavora dietro MongoDB® ha assicurato che, con la sua ricca integrazione con le tecnologie Big Data come Hadoop, è in grado di integrarsi bene nel Big Data Stack e aiutare a risolvere alcuni complessi problemi di architettura quando si tratta di archiviazione, recupero, elaborazione, aggregazione e immagazzinamento dei dati. Resta sintonizzato per il nostro prossimo post sulle prospettive di carriera per coloro che intraprendono Hadoop con MongoDB®. Se stai già lavorando con Hadoop o semplicemente acquistando MongoDB®, dai un'occhiata ai corsi che offriamo per MongoDB® qui

Scopri di più sui concetti di Hadoop. Dai un'occhiata a questo Corso sui Big Data online , che è stato creato da Top Industrial Working Experts.