Nota:questo articolo è stato originariamente redatto nel 2015, ma è stato aggiornato nel 2019 per riflettere la nuova integrazione tra IRI Voracity e Knime (per Konstanz Information Miner), ora la più potente piattaforma di data mining open source disponibile.

Il data mining è la scienza che consente di ricavare conoscenze dai dati, in genere set di dati di grandi dimensioni in cui è necessario scoprire informazioni significative, tendenze e altre informazioni utili. Il data mining utilizza l'apprendimento automatico e metodi statistici per estrarre utili "pepite" di informazioni da quello che altrimenti sarebbe un set di dati molto intimidatorio.

Il data mining abbraccia più discipline informatiche e matematiche. Non è tanto un processo unitario quanto un termine generico per un insieme di azioni. Quattro attività generali che vengono eseguite durante l'estrazione includono: analisi dei dati esplorativi (EDA), modellazione descrittiva, modellazione predittiva e scoperta di modelli.

EDA utilizza metodi di visualizzazione statistica convenzionali o metodi grafici non convenzionali per vedere se è possibile trovare qualcosa di interessante nei dati.

Nella modellazione descrittiva, i dati vengono passati a una routine e producono verbi (generatori di dati) o aggettivi (descrizioni di dati) che sono alla base della formazione dei dati. Ciò include metodi che associano i dati a una distribuzione di probabilità, clustering e modelli di dipendenza.

La modellazione predittiva utilizza metodi di regressione e classificazione per impostare uno standard per la previsione di futuri punti dati sconosciuti. La regressione è un'analisi puramente matematica che adatta un'equazione a un set di dati per prevedere il valore successivo. La modellazione predittiva può anche basarsi su regole di modello e tendenze di relazione (o anche causa ed effetto specificamente identificate) che sono state scoperte utilizzando il metodo dell'analisi logica dei dati (LAD).

Il rilevamento di modelli tramite LAD classifica le nuove osservazioni in base alle precedenti classificazioni delle osservazioni e utilizza funzioni di ottimizzazione, combinatoria e booleana per migliorare la precisione dell'analisi.

Per la maggior parte, questi metodi possono solo indicare quali voci di dati sono correlate, ma non i motivi o il modo in cui sono correlate. È possibile spiegare cosa caratterizza una classe/cluster da un'altra trovando queste regole o schemi, e gli argomenti sono elencati in vari modi a seconda dei dati stessi.

Le applicazioni per il data mining possono variare dal marketing aziendale alla medicina, dal rilevamento delle frodi nel settore bancario e assicurativo all'astronomia, dalla gestione delle risorse umane al settore del marketing di catalogo e così via. La professione medica l'ha trovato utile per distinguere tra attributi di persone con diversi tassi di progressione della malattia. I negozi al dettaglio stanno ora utilizzando il data mining per comprendere meglio le abitudini di spesa dei consumatori, rilevando quali articoli vengono acquistati insieme e la loro relazione, nonché il modo migliore per fare pubblicità ai propri clienti. E gran parte del mondo aziendale ora si affida al data mining per calcolare, eseguire e giustificare le principali decisioni aziendali.

Tuttavia, come ormai tutti sanno dalla recente intensa copertura mediatica dello scandalo dei record telefonici NSA-Verizon, anche il data mining può essere estremamente controverso. Nel caso tu abbia vissuto sotto una roccia, ecco una breve sinossi:

Il 5 giugno 2013, il quotidiano britannico The Guardian ha pubblicato un rapporto esclusivo secondo cui milioni di record di clienti di Verizon, uno dei maggiori fornitori di telecomunicazioni negli Stati Uniti, sono stati raccolti dalla US National Security Agency, in risposta a un ordine riservato dalla Corte di sorveglianza dell'intelligence straniera degli Stati Uniti. I servizi di rete aziendale di Verizon sono stati costretti a consegnare tutti i metadati di telefonia creati dal provider di servizi mobili negli Stati Uniti e all'estero. Di conseguenza, le critiche bipartisan e universali all'amministrazione Obama sono poi esplose da gruppi di difesa dei diritti civili e organi di informazione, sostenendo l'abuso presidenziale del potere esecutivo. Nessuna soluzione di questo incidente è in vista al momento della stesura di questo articolo. Ma rimarrà, senza dubbio, un ottimo esempio di come il data mining a volte può essere visto in una luce negativa, soprattutto per quanto riguarda i problemi di privacy e il pubblico in generale.

Quando si tratta di grandi volumi di dati statici o dinamici, ci saranno sicuramente problemi di prestazioni di calcolo e di I/O. Con database contenenti terabyte ed exabyte di dati, l'analisi dei dati può richiedere molto tempo e gli algoritmi di mining devono essere eseguiti in modo molto efficiente. Alcune altre difficoltà includono l'overfitting e i dati rumorosi.

L'overfitting di solito significa che non sono disponibili dati sufficienti. Il modello dati (in questo caso la descrizione globale dei dati) diventa troppo complesso perché ha troppi parametri relativi al numero di osservazioni. Ciò esagera piccole fluttuazioni nei dati, compromettendo così l'affidabilità del modello come base per fare previsioni.

I dati rumorosi, d'altra parte, si riferiscono a troppi tipi di dati sbagliati. Dati privi di significato, errati, non strutturati (illeggibili) o altrimenti corrotti aumentano i requisiti di archiviazione e/o richiedono l'eliminazione dell'analisi statistica prima che possano ostacolare l'accuratezza del data mining. I buoni algoritmi di data mining tengono conto dei dati rumorosi.

Il data mining è un singolo passaggio di un processo più ampio noto come knowledge discovery in database (KDD). KDD inizia innanzitutto con la preparazione dei dati: selezione, pre-elaborazione e trasformazione dei dati, in cui determini ciò che desideri studiare e lo configuri in un modo che possa essere estratto. Ciò significa rappresentare i dati come una matrice m—n e con una rappresentazione numerica dell'elemento di ciascun vettore di dati. Avanti, tu mio. E infine, puoi usare il vecchio noggin per interpretare e analizzare queste informazioni. Quindi, se i modelli e le tendenze nascosti non sono ancora abbastanza chiari, devi scavare un po' più a fondo.

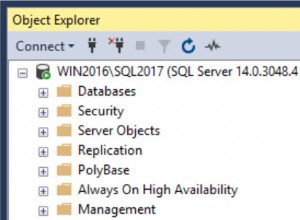

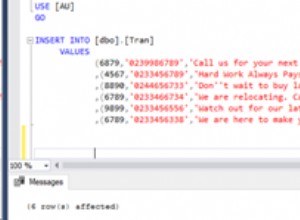

Il ruolo di IRI nel processo di data mining e KDD è quello di preparare e ristrutturare i big data per l'analisi attraverso molteplici funzioni di trasformazione dei dati ad alte prestazioni. In particolare, il pacchetto di manipolazione dei dati IRI CoSort può filtrare, manipolare e riformattare rapidamente i dati in modo che possano essere elaborati da algoritmi di data mining come queste suite di software di data mining. CoSort è anche il motore di elaborazione dati predefinito nella piattaforma di gestione dei dati IRI Voracity, progettato per un'ampia gamma di attività di profilazione, preparazione e discussione dei dati.

Per coloro che lavorano con CoSort nella GUI di IRI Workbench, BIRT è un plug-in gratuito di Eclipse con funzionalità di reporting grafico e business intelligence che includono alcune funzionalità di analisi e mining. Sia CoSort che BIRT Analytics utilizzano l'IDE Eclipse. Con il supporto del driver dati Open Data Access (ODA) in CoSort, anche l'integrazione del flusso di dati tra i due plug-in è perfetta e consente analisi what-if più rapide.

Per coloro che lavorano con Voracity nel 2019 e oltre, suggeriamo di installare il provider principale per la piattaforma di analisi Knime gratuita in IRI Workbench. Nella stessa finestra di Eclipse, il nodo sorgente (provider) di Voracity per Knime può consegnare i dati grezzi preparati da Voracity in memoria ai nodi Knime per applicazioni che richiedono analisi statistiche e predittive, data mining e machine/deep learning, rete neurale e intelligenza artificiale.

I contributori a questo articolo includono Roby Poteau e David Friedland