I dati sono potere e da questo potere derivano grandi responsabilità. Uno dei maggiori ostacoli nei dati è l'identificazione dei duplicati e la deduplicazione.

Lo scopo della deduplicazione dei dati è eliminare tutti i dati ridondanti nella tua azienda. I duplicati vengono creati in tutte le aree della tua attività, come il rappresentante di vendita che inserisce un nuovo record senza prima controllare il database, un marketer che carica un elenco di potenziali acquirenti senza verificare se il record esiste e un cliente che inserisce nuovamente le proprie informazioni perché si è dimenticato di avere già un account con te.

La deduplicazione dei dati garantisce una corretta gestione dei dati di tali record, una riduzione dell'archiviazione dei dati, comunicazioni di marketing più efficaci e una migliore analisi predittiva. I record duplicati possono effettivamente avere un enorme impatto sui record di apprendimento automatico e scienza dei dati, fornendo teoricamente ai clienti il doppio del potere predittivo e quindi creare una distorsione negli output.

Tuttavia, ogni grande idea comporta dei rischi e all'interno di una strategia di deduplicazione in base alla quale i dati vengono eliminati la maggior parte del tempo, possono esserci errori intrinseci.

In linea o post-elaborazione

I processi di deduplicazione in linea deduplicano i dati mentre vengono elaborati. Ciò significa che riduce immediatamente la quantità di dati, il che è ottimo ma spesso presenta problemi di prestazioni con la quantità di risorse necessarie per l'esecuzione di una strategia. Tuttavia, significa che hai bisogno di molto meno spazio su disco grezzo poiché i dati non vengono mai effettivamente inviati in primo luogo poiché la deduplicazione viene eseguita sul front-end.

È importante assicurarsi di disporre della potenza di elaborazione per la deduplicazione in linea e che non influisca sulle prestazioni. L'altro errore è presumere che ci siano zero casi per avere duplicati. Ci sono esigenze legittime per avere duplicati nel tuo sistema. I motivi possono essere di fatturazione, assistenza clienti, vendite e marketing, pertanto è una buona idea consultare tutti i reparti che toccano i dati prima di implementare l'elaborazione in linea.

Algoritmi

La deduplicazione è valida solo quanto gli algoritmi che viene alimentata, ovvero come vengono scoperti i record duplicati in primo luogo? Supponiamo di avere 100 copie di un file sui nostri sistemi perché ogni dipendente aveva la propria versione. Invece di archiviare più copie, le buone pratiche ti dicono di archiviarne solo una e di fare in modo che tutti i dipendenti puntino a quella. Cosa succede se uno dei dipendenti apporta una modifica al proprio file, il che significa che è leggermente diverso dagli altri? Corri il rischio di perdere dati. È importante assicurarsi che tutte le regole impostate abbiano un senso e non inizino a rimuovere set di dati univoci per errore.

Esistono alcuni algoritmi comuni utilizzati per la deduplicazione dei dati come SHA-1 o MD5 e le strutture ad albero di ricerca binaria che vale la pena esaminare per trovare ciò che è più appropriato per te.

Mentre la deduplicazione dei set di dati nell'esempio sopra può essere facilmente affrontata dai data scientist. Per i record di vendita e marketing, è un po' più difficile. Considera che le diverse aziende definiscono i duplicati in modo diverso, non è più un compito per il data scientist ma piuttosto per i capi di diversi dipartimenti. Pertanto, il primo passo è identificare ciò che rende un duplicato. Ad esempio, prendi un gigante della vendita al dettaglio come Walmart. Per la società di distribuzione, ogni sede di Walmart sarebbe considerata un record unico, tuttavia, per una società di software che vende in Walmart, considererebbe tutte le sedi come duplicati poiché vogliono vendere solo nella sede centrale. Lo stesso si può dire per la vendita in P&G, dove alcune attività vendono individualmente in ciascun marchio. Pertanto, vogliono tenerli tutti separati e applicare il collegamento genitore/figlio invece di deduplicare per identificare i diversi marchi. Pertanto, prima di eseguire la deduplicazione assicurati di aver definito tutte le regole prima di capire l'algoritmo da utilizzare per deduplicare i dati.

Crittografia

Con la protezione dei dati, capita spesso che i team di sicurezza abbiano i dati crittografati non appena entrano nell'azienda, il che significa che è impossibile deduplicarli poiché tutto è unico in questo contesto. Se utilizzi prodotti di replica e crittografia in linea con il software di deduplicazione, c'è un'alta probabilità che i file vengano replicati poiché semplicemente non possono selezionarli come blocchi di archiviazione univoci.

I prodotti per la protezione dei dati a volte sono consapevoli della deduplicazione, ma è fondamentale considerare come tutto si integra insieme.

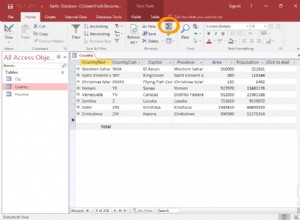

Deduplicazione manuale

La maggior parte delle aziende cercherà di deduplicare manualmente il proprio database occupando un'enorme quantità di risorse e tempo con un elevato rischio di errore umano. Oltre a ciò, con vasti set di dati, è praticamente impossibile che i processi manuali raccolgano tutto.

Ad esempio, cosa succede se John Smith acquista un paio di scarpe sul tuo sito web oggi. Ritorna domani ma si registra come J Smith perché ha dimenticato i suoi dati di accesso. La prossima settimana si iscrive di nuovo ma con un indirizzo email diverso. Ho menzionato solo tre campi di dati qui, ma inizia già a complicarsi, quindi immagina se hai 200 campi di dati dei clienti, come puoi assicurarti che siano mantenuti univoci?

È importante costruire da soli algoritmi completi se si esegue un processo manuale o acquisire strumenti di pulizia dei dati per farlo per te, risparmiando tempo e fatica.

Backup

La deduplicazione può andare storta! Prima di rimuovere i duplicati, è importante eseguire il backup di tutto e risolvere rapidamente eventuali problemi. Tornando al nostro esempio precedente, cosa succede se scopriamo che John Smith e J Smith sono in realtà persone diverse e hanno bisogno di riavere l'account? Hai bisogno di un processo che possa fare proprio questo, che è un requisito legale ora nell'UE (GDPR).

Una strategia di deduplicazione dei dati è importante poiché le aziende aumentano la propria impronta digitale. Con così tanti canali di comunicazione, un solo record duplicato ha la capacità di creare pregiudizi e potenzialmente portare a decisioni sbagliate. Detto questo, deve essere fatto correttamente per evitare le conseguenze della rimozione dei record errati o dell'alimentazione errata di algoritmi e della riduzione della velocità aziendale. Assicurati che la deduplicazione dei dati sia completamente realizzata all'interno della tua strategia di governance dei dati.