Il fatto che le organizzazioni debbano affrontare le sfide dei Big Data è comune al giorno d'oggi. Il termine Big Data si riferisce all'uso di un insieme di molteplici tecnologie, sia vecchie che nuove, per estrarre alcune informazioni significative da un'enorme pila di dati. Il set di dati non è solo ampio, ma presenta anche una serie unica di sfide nell'acquisizione, gestione ed elaborazione. A differenza dei dati persistenti nei database relazionali, che sono strutturati, il formato dei big data può essere strutturato, semistrutturato o non strutturato o raccolto da fonti diverse con dimensioni diverse. Questo articolo approfondisce gli aspetti fondamentali dei Big Data, le sue caratteristiche di base e fornisce un'idea degli strumenti e delle tecniche utilizzate per affrontarli.

Una panoramica

Il termine Big Data dà un'impressione solo della dimensione dei dati. Questo è vero in un certo senso, ma non fornisce l'intero quadro. Le sfide ad esso associate non riguardano solo le sue dimensioni. In effetti, l'idea si è evoluta per nominare un mare di dati raccolti da varie fonti, formati e dimensioni e, allo stesso tempo, difficili da sfruttare o ricavarne valore. L'ascesa della tecnologia emergente e il crescente utilizzo di Internet hanno dato impulso al volume e alla disparità. Il volume continua ad aumentare con ogni scambio di informazioni su Internet o anche con i minuscoli oggetti IoT che utilizziamo. Una semplice risposta a una telefonata o l'accensione della TVCC può generare una catena di dati. Oggi la maggior parte dei dispositivi è connessa online. Ora, se un'organizzazione vuole raccogliere tali informazioni online, ha bisogno di un processo di elaborazione speciale perché i dati generati saranno enormi. Inoltre, potrebbe non esserci uniformità nel formato dei dati acquisiti. Ciò aumenta la complessità in quanto abbiamo a che fare con dati strutturati, semi-strutturati o non strutturati. Gli strumenti che abbiamo utilizzato finora per organizzare i dati non sono in grado di gestire una tale varietà e volume. Pertanto, possiamo dire che il termine Big Data si applica effettivamente ai dati che non possono essere elaborati o analizzati tramite strumenti e tecniche tradizionali normalmente utilizzati per elaborare dati strutturati o semi-strutturati come l'utilizzo di database relazionali, XML e così via.

Le organizzazioni oggi sono piene di dati non strutturati o semistrutturati disponibili in formato grezzo. Questi dati possono essere una grande quantità di informazioni se elaborati e il valore ottenuto da essi. Ma il problema è come farlo. Le tecniche e gli strumenti tradizionali, come i database relazionali, sono inadeguati per gestire un volume così ampio di dati variegati. È anche un problema a doppio taglio per le organizzazioni, perché semplicemente distruggerle significherebbe perdere informazioni preziose, se presenti, e mantenerle è uno spreco di risorse. Pertanto, si cercano alcuni strumenti e tecniche per affrontare il problema. A volte, siamo abbastanza sicuri del suo valore potenziale che giace nel mucchio e possiamo raccogliere una miniera d'oro di informazioni ma, senza strumenti adeguati, è piuttosto faticoso per il processo aziendale trarne vantaggio. I dati oggi sono enormi ed esplosi come qualsiasi cosa negli ultimi anni; sembra che non ci sia modo di fermarlo, comunque.

Esplosione di informazioni

I big data stanno diventando sempre più grandi ogni minuto in quasi tutti i settori, che si tratti di tecnologia, media, vendita al dettaglio, servizi finanziari, viaggi e social media, solo per citarne alcuni. Il volume di elaborazione dei dati di cui stiamo parlando è sbalorditivo. Ecco alcune informazioni statistiche per darti un'idea:

- I canali meteo ricevono 18.055.555 richieste di previsioni ogni minuto.

- Gli utenti Netflix trasmettono in streaming 97.222 ore di video ogni minuto.

- Gli utenti Skype effettuano 176.220 chiamate al minuto.

- Gli utenti di Instagram pubblicano 49.380 foto ogni minuto.

Questi numeri crescono ogni anno, con un numero crescente di persone che utilizzano Internet. Nel 2017, l'utilizzo di Internet ha raggiunto il 47% (3,8 miliardi di persone) della popolazione mondiale. Con un numero sempre crescente di dispositivi elettronici, i nostri dati di output approssimativi sono stimati in 2,5 quintilioni di byte al giorno e in crescita.

Le statistiche di Ricerca Google mostrano 3,5 miliardi di ricerche al giorno, ovvero in media oltre 40.000 ricerche al secondo. Inoltre, non dovremmo perdere che anche altri motori di ricerca stanno effettuando ricerche. L'Email Statistics Report, 2015-2019 di Radicati Group, Inc., mostra 2,9 miliardi di utenti di posta elettronica entro il 2019.

Nel tentativo di stimare quante foto verranno scattate nel 2017:se ci fossero 7,5 miliardi di persone nel mondo nel 2017, con circa 5 miliardi di telefoni cellulari, un'ipotesi probabile è che l'80% di quei telefoni abbia una fotocamera integrata. Ciò significa che ci sono circa 4 miliardi di persone che usano le loro macchine fotografiche. Se scattano 10 foto al giorno, che equivalgono a 3.650 foto all'anno per persona, si ottengono circa 14 trilioni di foto all'anno.

Pertanto, quando diciamo Big Data, ci si riferisce essenzialmente a dati o set di record troppo grandi per essere ipotizzabili. Sono prodotti attraverso i motori di ricerca, l'informatica aziendale, i social network, i social media, la genomica, la meteorologia, le previsioni del tempo e molte altre fonti. Questo chiaramente non può essere gestito utilizzando gli strumenti e le tecniche di gestione dei database esistenti. I Big Data aprono un'arena di grandi sfide in termini di archiviazione, acquisizione, gestione, manutenzione, analisi, ricerca, nuovi strumenti per gestirli e simili.

Caratteristiche dei Big Data

Come per tutte le grandi cose, se vogliamo gestirle, dobbiamo caratterizzarle per organizzare la nostra comprensione. Pertanto, i Big Data possono essere definiti da una o più di tre caratteristiche, le tre V:alto volume , alta varietà e alta velocità . Queste caratteristiche sollevano alcune importanti domande che non solo ci aiutano a decifrarlo, ma danno anche un'idea su come gestire dati enormi e disparati a una velocità gestibile in un lasso di tempo ragionevole in modo da poterne ricavare valore, fare alcuni analisi in tempo reale e fornire rapidamente una risposta successiva.

- Volume: Il volume si riferisce all'enorme dimensione dei dati in continua esplosione del mondo informatico. Si pone la questione della quantità di dati.

- Velocità: La velocità si riferisce alla velocità di elaborazione. Si pone la questione della velocità con cui vengono elaborati i dati.

- Varietà: La varietà si riferisce ai tipi di dati. Si pone la questione di quanto siano disparati i formati dei dati.

Nota che caratterizziamo i Big Data in tre V, solo per semplificare i suoi principi di base. È del tutto possibile che la dimensione possa essere relativamente piccola, ma troppo variegata e complessa, oppure può essere relativamente semplice ma un enorme volume di dati. Pertanto, oltre a queste tre V, possiamo facilmente aggiungerne un'altra, Veracity . Veracity determina l'accuratezza dei dati in relazione al valore aziendale che vogliamo estrarre. Senza veridicità, è impossibile per un'organizzazione applicare le proprie risorse per analizzare la pila di dati. Con una maggiore precisione per quanto riguarda il contesto dei dati, c'è una maggiore possibilità di ottenere informazioni preziose. Pertanto, la veridicità è un'altra caratteristica dei Big Data. Le aziende sfruttano i dati strutturati, semi-strutturati e non strutturati da e-mail, social media, flussi di testo e altro ancora. Ma, prima dell'analisi, è importante identificare la quantità e i tipi di dati in considerazione che potrebbero influire sui risultati aziendali.

Strumenti e tecniche

Intelligenza artificiale (AI), IoT e social media stanno guidando la complessità dei dati attraverso nuove forme e fonti. Ad esempio, è fondamentale che, in tempo reale, i big data provenienti da sensori, dispositivi, reti, transazioni vengano acquisiti, gestiti ed elaborati con bassa latenza. I Big Data consentono ad analisti, ricercatori e utenti aziendali di prendere decisioni più informate più velocemente, utilizzando dati storici che altrimenti sarebbero irraggiungibili. È possibile utilizzare l'analisi del testo, l'apprendimento automatico, l'analisi predittiva, il data mining e l'elaborazione del linguaggio naturale per estrarre nuove informazioni dalla pila di dati disponibile.

La tecnologia si è evoluta per gestire enormi volumi di dati, che in precedenza erano costosi e dovevano avere l'aiuto di supercomputer. Con l'emergere di social media come Facebook, motori di ricerca come Google e Yahoo!, i progetti Big Data hanno preso slancio e sono cresciuti come lo sono oggi. Tecnologie come MapReduce, Hadoop e Big Table sono state sviluppate per soddisfare le esigenze odierne.

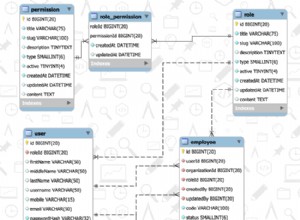

I repository NoSQL sono menzionati anche in relazione ai Big Data. È un database alternativo rispetto ai database relazionali. Questi database non organizzano i record in tabelle di righe e colonne come si trovano nei database relazionali convenzionali. Esistono diversi tipi di database NoSQL, come Content Store, Document Store, Event Store, Graph, Key Value e simili. Non usano SQL per le query e seguono un modello architettonico diverso. Si scopre che facilitano l'analisi dei Big Data in modo favorevole. Alcuni nomi popolari sono:Hbase, MongoDB, CouchDB e Neo4j. Oltre a loro, ce ne sono molti altri.

Conclusione

I Big Data hanno aperto una nuova opportunità alla raccolta di dati e all'estrazione di valore da essi, che altrimenti sarebbero stati devastati. È impossibile acquisire, gestire ed elaborare Big Data con l'ausilio di strumenti tradizionali come i database relazionali. La piattaforma Big Data fornisce gli strumenti e le risorse per estrarre informazioni dai voluminosi, vari e veloci dei dati. Queste pile di dati ora dispongono di mezzi e contesto praticabile da utilizzare per vari scopi nel processo aziendale di un'organizzazione. Pertanto, per individuare esattamente di quale tipo di dati stiamo parlando, dobbiamo comprenderlo e le sue caratteristiche come passaggio principale.