Big Data è utile solo quando possiamo farci qualcosa; altrimenti, è semplicemente un mucchio di spazzatura. Tuttavia, lo sforzo richiesto per scavare a volte è come cercare di trovare un ago in un pagliaio. Un modello significativo emerge solo con molta analisi. L'analisi si mette al lavoro, cerca di analizzare i dati con ogni macchina disponibile, cervello compreso. Questi macchinari non sono altro che strumenti accompagnati da potenza di calcolo per esplorare i dati. Questo articolo tenta di fornire una breve panoramica delle tecniche utilizzate con l'analisi dei big data.

Una panoramica

Prima dell'analisi, i dati vengono raccolti da diverse fonti. È necessario organizzarlo in modo che un analista possa svolgere il proprio lavoro e fornire alcuni prodotti di dati tangibili utili per il processo aziendale dell'organizzazione. I dati raccolti possono trovarsi in vari stati, come dati grezzi non strutturati, dati semistrutturati, dati strutturati e così via. Queste sono le materie prime dell'analisi dei big data. Quindi, il complesso processo di esplorazione inizia a svelare schemi nascosti, correlazioni e intuizioni. Gli analisti prendono l'aiuto di tutti gli strumenti e le tecnologie disponibili nel processo di analisi e cercano di trarne un certo valore. Pertanto, quali analisi dei dati significa è il processo di esame di un ampio insieme di dati (con una o più caratteristiche che si riferiscono ad esso come big data) e scoprire alcune informazioni significative.

Analisi di base

L'analista deve inizialmente assicurarsi che i dati abbiano un certo valore prima di impiegare sforzi e risorse rigorosi per analizzare i dati. A volte, una semplice visualizzazione e statistiche sono ciò di cui hai bisogno per ottenere alcuni risultati. Le tecniche di base sono le seguenti:

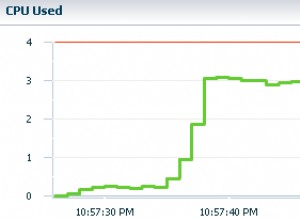

- Monitoraggio di base: Anche il monitoraggio di un grande volume di dati in tempo reale è uno dei modi per ottenere informazioni dettagliate. Ad esempio, semplicemente monitorando i dati meteorologici raccolti nel corso degli anni, possiamo ottenere un'idea abbastanza approfondita dei tipi di condizioni climatiche di una regione geografica. Inoltre, le informazioni in tempo reale su vento, umidità, pressione, temperatura e così via possono far luce sul tipo di tempesta imminente. Se colleghiamo ogni punto, possono esserci numerosi parametri con enormi informazioni. Oggi, se riusciamo a cogliere la tendenza di tutti i tweet nei social media, possiamo facilmente farci un'idea delle masse e di cosa stanno pensando. L'analista politico spesso lo fa e quello che fa è semplicemente monitorare i dati in streaming.

- Tagliare e tagliare a dadini: Questa tecnica comune si riferisce alla segmentazione di un grande blocco di dati in set di dati più piccoli in modo che diventino facili da visualizzare e comprendere. La segmentazione viene eseguita ripetutamente fino a ottenere una dimensione più gestibile. Query specifiche vengono attivate per ottenere informazioni dettagliate o eseguire calcoli, creare una rappresentazione grafica o applicare formule statistiche su insiemi di dati più piccoli. Questo aiuta ad accertare una certa prospettiva per l'analista seduto nel mare dei dati. Si possono avere domande solo quando una prospettiva è definita. Pertanto, la tecnica aiuta a creare uno spazio di query quando si lavora con grandi volumi di dati.

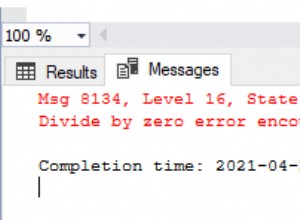

- Rilevamento di anomalie: Anomalia , qui, si riferisce al cambiamento improvviso di eventi che si verifica in un ambiente che può innescare effetti diversi. Ad esempio, un'improvvisa caduta del Sensex può avere numerose cause, come bruschi cambiamenti socio-politici, guerre o calamità naturali o molte altre cose. Ma, se siamo in grado di rilevare l'anomalia, fornisce una preziosa intuizione per comprendere e analizzare la situazione. Anche una semplice serie di statistiche o osservazioni può aiutare a risolvere il problema.

Analisi avanzata

Come dovrebbe essere ovvio, l'analisi non è sempre diretta o semplice. Infatti, in molti casi dipende dalla complessità dei dati e il tipo di informazioni che vogliamo estrarre determina il tipo di analisi che vogliamo coinvolgere nel processo. L'analisi avanzata utilizza algoritmi per analisi complesse su vari formati di dati, come l'utilizzo di machine learning, reti neurali, modelli statistici sofisticati, analisi del testo e tecniche avanzate di data mining per ottenere uno schema significativo dal volume di dati.

- Analisi del testo: L'analisi del testo è il processo in cui le informazioni significative vengono derivate da una raccolta di dati non strutturati. La gestione dei dati non strutturati è una parte enorme dell'analisi dei big data; pertanto, vengono utilizzate tecniche specifiche per analizzare ed estrarre informazioni e infine trasformarle in informazioni strutturate. Le informazioni strutturate vengono quindi utilizzate per analizzare ulteriormente in modo conveniente. Le tecniche impiegate con l'analisi del testo derivano dalla linguistica computazionale, dalla statistica e da altre discipline informatiche.

- Modellazione predittiva: La modellazione predittiva utilizza soluzioni di data mining e probabilità per prevedere i risultati. La tecnica viene applicata a dati strutturati e non strutturati per prevedere il risultato. Ad esempio, un sistema predittivo può prevedere il numero di consumatori di un prodotto che passano a un altro prodotto in base ad alcuni attributi comportamentali disponibili o prevedere il cambiamento nella mentalità delle persone osservando la tendenza del tweeting nei social media, che può avere un decisivo impatto sociopolitico risultato di una campagna politica.

- Utilizzo di algoritmi statistici di data mining: Esistono numerose altre tecniche avanzate di previsione che utilizzano statistiche e soluzioni di data mining. Esistono tecniche come l'analisi dei cluster, la micro segmentazione, l'analisi di affinità e simili.

Conclusione

Questo articolo, ovviamente, scalfisce solo la superficie dell'argomento, ma forse dà un assaggio di quella che verrà chiamata analisi dei big data. La tendenza all'uso dei big data da parte delle organizzazioni sta guadagnando rapidamente slancio per tutti i buoni e cattivi motivi. Il risultato è senza dubbio aperto all'uso e all'abuso e non possiamo fermarlo. Nuovi strumenti e tecnologie vengono creati per aiutare nel processo di analisi dei big data. Forse la consapevolezza è l'unica tregua.