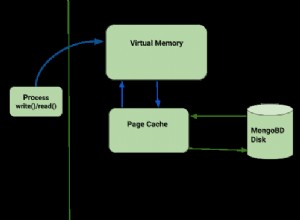

Penso di aver trovato il problema:mongodb-hadoop ha un modificatore "statico" sulle sue istanze di codifica/decodificatore BSON in core/src/main/java/com/mongodb/hadoop/input/MongoInputSplit.java. Quando Spark viene eseguito in modalità multithread, tutti i thread tentano di deserializzare utilizzando lo stesso istanze codificatore/decodificatore, che presumibilmente hanno risultati negativi.

Patch sul mio github qui (hanno inviato una richiesta pull a monte)

Ora sono in grado di eseguire Spark->mongo collection count() con 8 core multithread da Python!